En los últimos días, algunos usuarios se quejaron en Twitter respecto de que el algoritmo detrás de Apple Card tiene una configuración sexista porque, ante una misma situación financiera, les otorga mayor crédito a los hombres que a las mujeres.

Ahora, a raíz de una cantidad de quejas que se viralizaron en las redes, los reguladores financieros de Estados Unidos están investigando las prácticas en las que se basa este instrumento financiero.

Todo comenzó con un tuit del desarrollador de software y creador de Ruby on Rails David Heinemeier Hansson. El emprendedor publicó en Twitter que Apple Card le ofrecía a él una línea de crédito 20 veces más alta que a su esposa, a pesar de que los dos presentan declaraciones de impuestos conjuntas, y que, según dice, no pareciera haber un motivo financiero que justificara esta diferencia.

/arc-anglerfish-arc2-prod-infobae.s3.amazonaws.com/public/5HJUM5PQ7NA47FFXM7EDPKSGC4.jpg)

Además, criticó el hecho de que aún cuando ella paga la totalidad de la cuota en fecha, la tarjeta le impide realizar nuevos gastos hasta el próximo período de facturación. En otro tuit contó que buscaron respuestas por parte de TransUnion, una agencia estadounidense de informes de crédito al consumo y se dieron cuenta de que el puntaje crediticio de ella era incluso superior al de él lo cual hace menos comprensible el motivo por el cual Apple Card le otorga un beneficio menor.

Su comentario no fue el único: hubo otros usuarios que se quejaron sobre lo que parece ser una decisión sexista, entre ellos está Steve Wozniak. El cofundador de Apple respondió uno de los tuits de Hansson diciendo que él había atravesado una situación similar. “Yo obtuve un límite de crédito 10 veces superior. No tenemos cuentas de crédito o bancaria separadas, ni otros activos separados”, explicó.

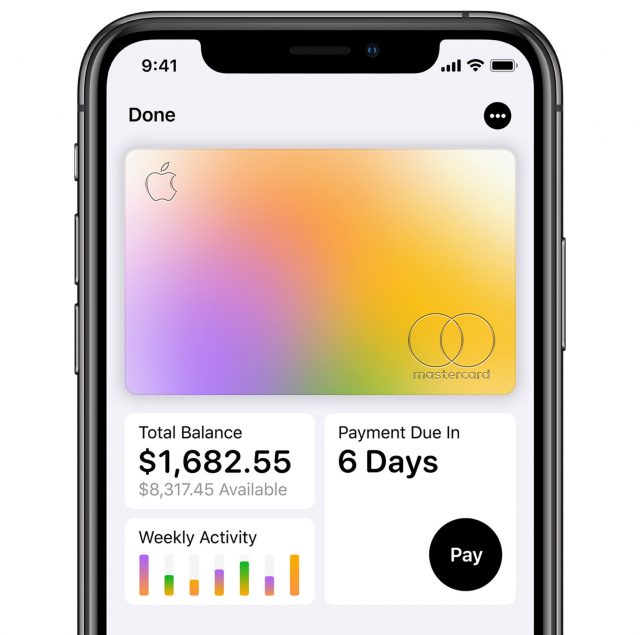

La tarjeta de crédito de Apple se lanzó en agosto, en el marco de un acuerdo con Goldman Sachs. Este lanzamiento es parte de una estrategia para incrementar los ingresos que llegan por parte de la prestación de servicios, un segmento que viene creciendo en los últimos meses, por sobre la venta de iPhones.

/arc-anglerfish-arc2-prod-infobae.s3.amazonaws.com/public/UCNTMXPIXNA3HEXO3D45WK5U2I.jpg)

¿Qué pudo haber generado estas diferencias? Hansson contó que su esposa se puso en contacto con representantes de Apple, quienes se limitaron a decir que no se trata de discriminación sino que simplemente son decisiones basadas en un algoritmo.

Ahora bien: ¿qué hay detrás de ese algoritmo? ¿Qué información nutrió el desarrollo de ese sistema? ¿Cómo se sabe que no hubo sesgos en el desarrollo de ese algoritmo o en la selección de información que se utilizó para programarlo? Son varias preguntas que no tienen respuesta por el momento.

Lo que deja en claro esta situación es que a medida que crece el uso de inteligencia artificial en la industria resulta necesario instrumentar mecanismos para asegurarse de que las decisiones de las máquinas no vayan en detrimento de algunos usuarios por sesgos. No es la primera vez que se identifican problemas de este estilo. Hubo varios casos donde, por diferentes cuestiones, los algoritmos terminaron reproduciendo sesgos o discriminando de diferentes formas.

La entidad reguladora de seguros en Nueva York anunció la semana pasada que inició una investigación sobre un algoritmo de UnitedHealth Group Inc. que habría dado mayor prioridad a la atención de pacientes blancos que a pacientes negros, según publicó el New York Times.

De acuerdo con una investigación de la Universidad Carnegie Mellon realizada en 2015, las mujeres tenían, en aquel entonces, menos chance que los hombres de ver anuncios sobre empleos bien remunerados en la web.

En 2016, Microsoft tuvo que finalizarcon el proyecto de Tay, un bot para Twitter, cuando resultó que, en menos de 24 horas de entrar en acción pasó de ser divertida y amable a agredir a otros usuarios y a hacer apología nazi. El sistema se nutría de la interacción con otros usuarios y así fue como tras ser expuesta a diferentes comentarios de odio en esa plataforma se conviritó en una inteligencia artificial nociva.

La lista sigue. El punto en cuestión es que no es la tecnología per se lo que genera discriminación sino la forma en que se desarrolla y aplica.

Goldman Sachs publicó un comunicado donde dijo que los solicitantes de Apple Card fueron evaluados de forma independiente, de acuerdo con sus ingresos y solvencia, teniendo en cuenta factores como la puntuación crediticia y sus deudas personales.

En este sentido, dijo que era posible que dos miembros de la familia recibieran créditos diferentes, y aseguraron que no han tomado ni tomarán decisiones en función de cuestiones de género.

/arc-anglerfish-arc2-prod-infobae.s3.amazonaws.com/public/TQNLV5DU6RBEDMYOZBI3YO4GZU.jpg)

Por su parte, el Departamento de Servicios Financieros de Nueva York dijo que estaba iniciando una investigación al respecto. “La ley de Nueva York prohíbe la discriminación contra las clases protegidas de individuos”, escribió Linda Lacewell, la superintendente del Departamento de Servicios Financieros del Estado de Nueva York, en un post.

Habrá que ver a qué conclusión llega esta investigación. Lo que sí queda claro es que en la era del machine learning, surgen nuevos desafíos. Las máquinas son programadas por humanos. En ese sentido, es fundamental que los humanos que generan esos programas, y seleccionan la información que se usa para nutrir los sistemas de aprendizaje automático tengan en cuenta la diversidad y contemplen la mayor cantidad de variantes posibles para evitar la reproducción automática de patrones discriminatorios.

Kate Crawford, investigadora de AI Now Research Institute de la Universidad de Nueva York y profesora del MIT Media Lab, durante una entrevista con Infobae, que se llevó a cabo en noviembre de 2018, advertía: “es muy difícil lidiar con los sesgos”, advirtió la especialista. Y en este sentido dijo que es fundamental que se generen, en compañías y gobiernos, equipos multidisciplinarios, que incluyan filósofos y sociólogos, a la hora de desarrollar este tipo de tecnología.

“A la hora de analizar estas tecnologías hay que preguntarse quién recibirá los mayores beneficios y quiénes corren los mayores riesgos”, reflexionó Crawford. Sin dudas, es una pregunta que hay que comenzar a hacerse antes de implementar cualquier desarrollo que puede impactar directamente en la vida de los usuarios como puede ser un sistema que decida quién obtiene préstamos o cómo se implementarán diferentes sistemas.